A maior potência econômica mundial está prestes a passar por um novo processo eleitoral para escolher seu líder máximo. Quatro anos se passaram desde que as redes sociais se tornaram o ponto de origem para uma pesada campanha de desinformação que tentou ativamente influenciar os resultados. A expectativa dos especialistas é que o novo pleito repita a guerra informacional de 2016 e serão necessários mecanismos para buscar suavizar o seu impacto.

De acordo com um levantamento científico realizado pelo Professor Jacob Shapiro da Universidad de Princeton (PDF) e abalizado pela Microsoft, nada menos que 96 campanhas de influenciadores estrangeiros foram orquestradas contra o processo eleitoral de 30 países, entre 2013 e 2019, utilizando mídias digitais. Entre as nações afetadas, estaria o Brasil, além de França, Canadá, Estados Unidos e outros. Ainda segundo esse estudo, 74% dessas campanhas maliciosas distorciam fatos que podiam ser objetivamente comprovados, para difamar indivíduos, inflamar a polarização do tecido social ou persuadir a opinião pública.

O quadro se agravou com o advento da pandemia do novo coronavírus, com notícias falsas e politização de fatos que levaram a impactos que ainda precisam ser mensurados e cujos resultados podem inclusive levar a prejuízos pesados à infraestrutura social e a saúde pública.

Diante desse quadro, a Microsoft anunciou sua estratégia no combate aos deep fakes, à falsificação de notícias e ao processo de reeducação informacional necessário para o desenvolvimento de senso crítico.

Microsoft Video Authenticator

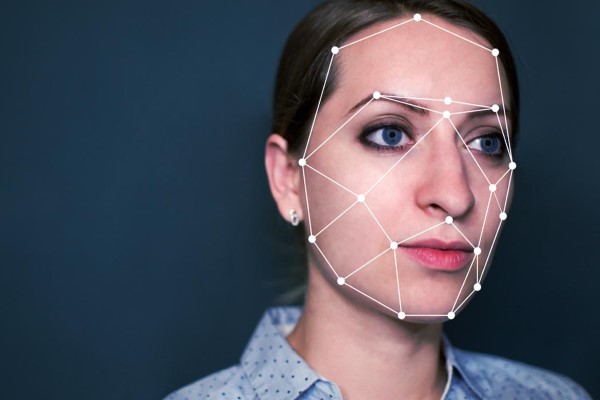

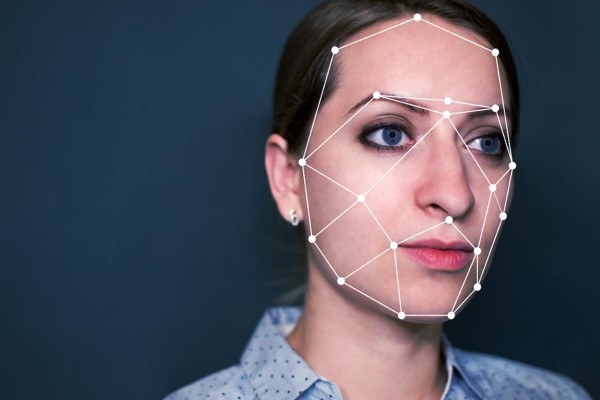

Em sua abordagem, a Microsoft tenta combater tecnologia com tecnologia, embora reconheça que não exista uma ferramenta única que possa solucionar todos os problemas. Além da ameaça dos Deep Fakes de vídeo, a empresa aponta também a questão das imagens e dos áudios adulterados por Inteligência Artificial, englobando todos esses riscos sob o rótulo de mídia sintética, um novo tipo de conteúdo complicado de ser identificado a olho nu.

Por causa de suas características geradas por algoritmo, a proposta da Microsoft é reverter os mesmos princípios, fogo contra fogo. Entra nessa batalha o Microsoft Video Authenticator, um recurso de aprendizado de máquina capaz de aferir o grau de confiabilidade de uma mídia a partir de sinais de manipulação. De acordo com o anúncio oficial, o sistema funciona “detectando o limite de mesclagem dos elementos deepfake e sutil desvanecimento ou tons de cinza que podem não ser detectados pelo olho humano”, entre outros fatores.

A tecnologia é resultado da colaboração entre diversos departamentos de pesquisa da Microsoft, a partir do banco de dados público do Face Forensic++. O algoritmo foi testado usando o DeepFake Detection Challenge Dataset, gerando então um poderoso recurso baseado em modelos de ponta gerados pela comunidade científica para a detecção de mídias sintéticas.

“Esperamos que os métodos de geração de mídia sintética continuem a crescer em sofisticação. Como todos os métodos de detecção de IA têm taxas de falha, temos que entender e estar prontos para responder aos deepfakes que escapam aos métodos de detecção”, se comprometeu a Microsoft.

Por enquanto o Microsoft Video Authenticator não está disponível para os usuários domésticos, mas foi integrado ao arsenal da iniciativa Reality Defender 2020 (RD2020). A proposta do projeto nesse momento é fornecer recursos para organizações interessadas em manter a transparência do processo democrático, como entidades jornalísticas e campanhas políticas, sem fins lucrativos ou ligação partidária.

Na prática, a utilização do Microsoft Video Authenticator é bem simples para quem tem acesso ao recurso: basta fazer o upload da mídia a ser analisada e aguardar o resultado. No caso de vídeo, a ferramenta é capaz até mesmo de oferecer dados frame a frame, para reconhecer o momento na filmagem em que ocorreu a manipulação.

Conteúdo real

Ainda segundo a Microsoft, “existem poucas ferramentas hoje para ajudar a garantir aos leitores que a mídia que estão vendo online veio de uma fonte confiável e que não foi alterada”. Portanto, para esse desafio em específico, a empresa está desenvolvendo uma espécie de selo de autenticação para notícias.

A tecnologia é baseada em dois fatores. O primeiro deles é um recurso embutido no Microsoft Azure que habilita aos produtores de conteúdo certificar seu material usando hashes que acompanharão aquele conteúdo através da web na forma de metadados. Para interpretar e reconhecer esse selo, entra a segunda parte da tecnologia: um leitor, que pode ser inclusive um plugin para navegadores, que identifica o certificado e assinala a autenticidade da notícia. É uma forma de assinar o conteúdo distribuído pela internet e fornecer com garantia seu atestado de procedência.

Essa iniciativa reúne a expertise dos times da Microsoft Research com Microsoft Azure e foi projetada para ser uma parte integrante do Defending Democracy Program, impulsionando o chamado Project Origin.

Project Origin é uma coalizão de forças entre os produtores de conteúdo BBC, CBC/Radio-Canada e The New York Times com a Microsoft. Laura Ellis, diretora de tecnologia da BBC explica o perigo que o projeto busca oferecer: “tradicionalmente, nossas rotas de transmissão ou publicação têm sido seguras, um transmissor ou um servidor web, mas uma vez que o material vai além de nossos próprios canais e é compartilhado nas redes sociais, ele fica vulnerável à manipulação, embora ainda mantenha a aparência de ser um conteúdo de boa-fé”.

A ideia é possuir um sistema capaz de “marcar” conteúdo e que siga sendo eficiente após sucessivas camadas de replicação, compressão, redimensionamento etc, a ponto de salvaguardar a autenticidade original. Considerando que as próprias redes sociais aplicam modificações não-maliciosas ao conteúdo publicado, ajustando de acordo com suas especificidades, como reconhecer uma alteração mal-intencionada? Os primeiros passos estão sendo dados agora e a tecnologia está em fase de testes.

De acordo com Ellis, o objetivo final é ter uma tecnologia “simples de usar, transparente e com padrões abertos que podem ser amplamente adotados para o bem público”.

Você consegue identificar uma mentira?

Infelizmente, de nada adiantam as melhores intenções, as melhores ferramentas e as fontes mais confiáveis se o receptor da mensagem não tem a vontade ou a percepção para separar verdades de mentiras. É necessário educar o consumidor para a análise crítica das informações e identificação de fatos.

A Microsoft também está ciente desse componente da equação e estabeleceu uma parceria com a University of Washington (UW), a Sensity e o jornal USA Today para buscar soluções que incentivem uma chamada “alfabetização midiática”.

“O conhecimento prático da mídia pode permitir que todos nós pensemos criticamente sobre o contexto da mídia e nos tornemos cidadãos mais engajados enquanto ainda apreciamos a sátira e a paródia. Embora nem todas as mídias sintéticas sejam ruins, mesmo uma curta intervenção com recursos de alfabetização midiática tem mostrado que ajuda as pessoas a identificá-las e tratá-las com mais cautela”, explica a empresa.

Com essa meta no horizonte, a Microsoft produziu uma experiência interativa que conduz o usuário através de uma série de conteúdos que podem ou não ser falsificados, além de trazer informações relevantes sobre o tema. Para muitos, esse pode ser o primeiro contato com um Deep Fake dentro de um ambiente controlado e o processo funciona como uma espécie de treinamento para o mundo real e mídias sintéticas geradas com o propósito de manipulação. O serviço Spot the Deepfake está disponível para todos, em Inglês ou Espanhol.

Como uma das lições da experiência, é importante lembrar que “os criadores de deepfakes manipuladores e outras mídias geralmente tentam fazer com que as pessoas pensem com o coração em vez de com a cabeça. Uma das melhores coisas a fazer é monitorar como você está reagindo emocionalmente a um vídeo ou foto e, se tiver uma resposta forte, pergunte-se por que o criador dessa mídia pode querer que você se sinta assim”.