É inegável que a pandemia mudou a face do mercado de trabalho. Nunca tantos aderiram às videoconferências como agora e o mercado que orbita em torno desse segmento explodiu, desde fabricantes de câmera até empresas de aplicativos de streaming (como o Zoom).

Entretanto, um dos grandes desafios para esse cenário ainda é o embate entre a taxa de transmissão e a qualidade do vídeo: de que adianta ter a melhor câmera disponível, um PC de ponta, uma internet de alta velocidade se o receptor não conta com uma boa conexão? O resultado é um imagem sofrível, um som picotado, quando não temos o famoso “travamento”.

A solução mais óbvia para tudo isso seria investir na distribuição em larga escala de uma internet mais rápida para todos, mas iniciativas desse tipo demoram para se concretizar, quando se concretizam. Uma segunda solução possível seria melhorar o processo de compactação de transmissão de vídeo através de codecs superiores, contudo esse é o Cálice Sagrado que empresas de mídia vem perseguindo por décadas e talvez tenhamos chegado no limite técnico de quantos dados se consegue espremer.

Pensando completamente fora da caixa, a Nvidia está usando uma vasta rede neural nativa na nuvem para substituir a compactação tradicional pela recriação em tempo real do vídeo a partir de algoritmos de Inteligência Artificial. Transmite-se menos dados, apenas o essencial, para que a imagem seja refeita com dedução gerada por máquina.

É feitiçaria?

Em termos bastante leigos, é como você chegar na delegacia para descrever um assaltante e um desenhista muito habilidoso reproduz a foto exata a partir do que ouve. O recurso batizado de Nvidia Maxine promete ser uma revolução na forma como consumimos vídeo na internet.

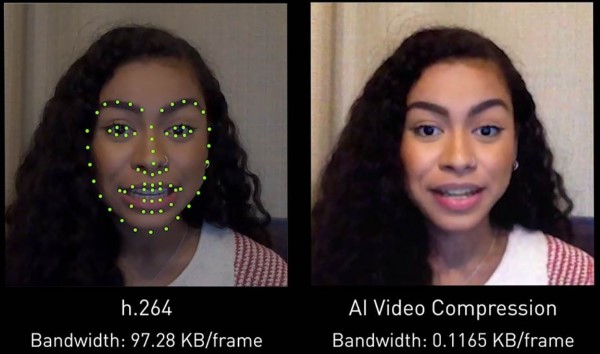

Para o consumidor final, nem mesmo é necessário possuir uma GPU Nvidia em seu dispositivo. Todo o processo acontece na nuvem, em um serviço que a empresa está oferecendo para fabricantes de soluções de transmissão, que tem o potencial de reduzir drasticamente a banda necessária para que uma videoconferência aconteça com qualidade. No exemplo apresentado, com dois vídeos que o olho humano considera similares, o codec h.264 exige quase 100 kb por frame, enquanto a “compressão” de Maxine consome somente 0.12 KB por frame, uma fração de quase um milésimo do original, embora a Nvidia esteja garantindo apenas um décimo do consumo.

“Queremos fornecer uma experiência melhor para comunicações de vídeo com IA para que mesmo pessoas que só têm acesso a largura de banda extremamente baixa possam atualizar de chamadas de voz para vídeo”, explicou Arun Mallya, um dos desenvolvedores envolvidos no projeto.

Esse milagre é possível ao registrar pontos chaves do rosto do participante e monitorar as mudanças durante a fala. Essas informações, e apenas essas informações, são transmitidas para a nuvem da Nvidia, no lugar de toda a grade de pixels capturada pela câmera. A partir das alterações dos pontos chaves, Maxine irá recriar o rosto e o cenário somente com as partes que mudam de frame para frame. É a quebra de limites entre imagem real e um avatar gerado por computador.

A nuvem de GPUs da Nvidia cria modelos de Inteligência Artificial usando as chamadas generative adversarial networks (GANs). GANs vem em pares, onde uma é uma rede geradora que produz amostras a partir do rosto real do usuário e uma outra rede é a discriminadora que identifica mudanças nas amostras usando algoritmos treinados em milhões de rostos anteriores. O resultado é uma mídia híbrida entre o verdadeiro e o sintético, um princípio muito parecido com o deep fake, mas gerado em tempo real com o poder de processamento de uma rede neural na nuvem.

O que começou quase como uma brincadeira da Nvidia lá atrás, se consolidou com um produto imprescindível no momento certo da indústria.

De acordo com o comunicado oficial, as vantagens são muitas: “isso corta custos para os provedores e oferece uma experiência de videoconferência mais suave para os usuários finais, que podem desfrutar de mais serviços baseados em IA ao mesmo tempo em que fazem streaming de menos dados em seus computadores, tablets e telefones”.

Mesmo que a transmissão original se dê em baixa resolução por limitações técnicas de banda ou equipamento, a tecnologia proposta pela Nvidia também é capaz de “escalar” para resoluções maiores, novamente usando aprendizado de máquina para cobrir as lacunas de informações ausentes no processo. É a aplicação do famoso DLSS já testado pela Nvidia em jogos eletrônicos, desta vez no mercado corporativo com vídeo real. Desta forma, é possível, então entregar uma qualidade homogênea de conferência para todos os participantes, sem a necessidade de recursos mais avançados.

Nos bastidores, Nvidia Maxine se apoia em microsserviços rodando em clusters de containers Kubernetes em GPUs da empresa. Essa infraestrutura, garantem os desenvolvedores, permitiria suporte a centenas de milhares de usuários simultâneos acessando a tecnologia de Inteligência Artificial.

O céu é o limite

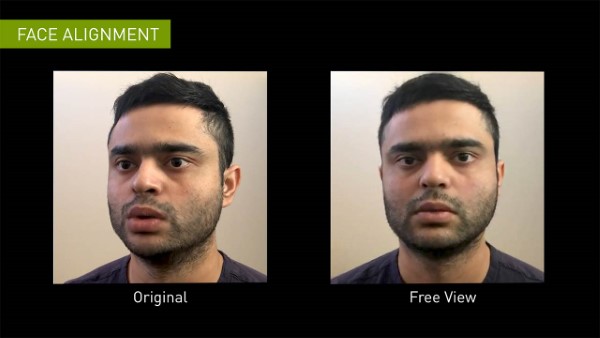

A partir do momento em que a transmissão não está mais limitada ao corpo físico original da pessoa, muitas possibilidades se abrem para a tecnologia. Quem não acha estranho ver um palestrante ou companheiro de reunião que não está olhando diretamente para a câmera, porque ela foi posicionada de forma desalinhada? Com Nvidia Maxine, a rede neural é capaz de alinhar o rosto do indivíduo, reconstruindo o que se supõe que esteja na parte inclinada.

“Com técnicas de visão computacional, podemos localizar a cabeça de uma pessoa em uma ampla variedade de ângulos e achamos que isso ajudará as pessoas a ter conversas mais naturais”, disse Ting-Chun Wang, outro desenvolvedor responsável pelo projeto.

Da mesma forma, é possível transferir os pontos chaves capturados do rosto real para uma figura completamente artificial, como um avatar animado. Por mais improvável que seja a nova face escolhida, como um alienígena ou um personagem de desenho, o avatar irá reproduzir com perfeição os gestos faciais e a leitura labial do rosto verdadeiro.

Além disso, o sistema possui recursos que vão além do vídeo e também afetam o áudio da transmissão. A mesma rede neural de Maxine é capaz de isolar ruídos do ambiente em tempo real e entregar recursos de tradução simultânea, closed captions e outras funções de acessibilidade antes impossíveis. Esse potencial combinado com o NVIDIA Jarvis permitiria inclusive a criação de assistentes virtuais capacitados para gerar respostas e conversação com modelos de aparência natural.

E o futuro?

Passado o entusiasmo da descoberta, é preciso refletir. O avanço da tecnologia de produção de mídia sintética aumenta o nível de alerta para o perigo dos Deep Fakes. Empresas como Microsoft estão empenhadas em desenvolver o caminho inverso: algoritmos capazes de identificar o mesmo nível de alteração produzido por Maxine.

Com dois gigantes em duas pontas competindo, e agentes hostis no meio tentando subverter o uso programado da tecnologia, o cenário daqui a alguns anos exigirá um usuário mais crítico, uma vez que as fronteiras entre o real e o virtual se tornarão mais confusas nas telas de nossos dispositivos. A partir de agora, “ver com seus próprios olhos” perde completamente o seu sentido.