A estripulias na Internet da Inteligência Artificial “adolescente” da Microsoft continuaram ontem em dez breves minutos de atividade, mas indicam que há algo bem errado com a pobre Tay…

O sistema desenvolvido para se comunicar como uma jovem americana no Twitter acordou de sua desativação e disparou nada menos que 7 mensagens por segundo e “confessou” fumar maconha.

Em uma semana, o projeto Tay foi de “menina dos olhos” das pesquisas da Microsoft sobre linguagem natural para um pesadelo completo de relações públicas. Anunciada com pompa e circunstância na quarta-feira passada, a Inteligência Artificial absorveu rapidamente o discurso de uma parcela de seus interlocutores e se tornou xenófoba, machista, racista e fã de Adolph Hitler em menos de 24 horas. Como resultado, os pesquisadores desligaram Tay para fazer ajustes.

O caso poderia ter se encerrado por aí como mais uma fábula sobre a selvageria que habita os porões da Internet, mas ontem, sem uma explicação oficial da Microsoft, Tay foi reativada para enviar uma torrente de mensagens, a maioria sem sentido:

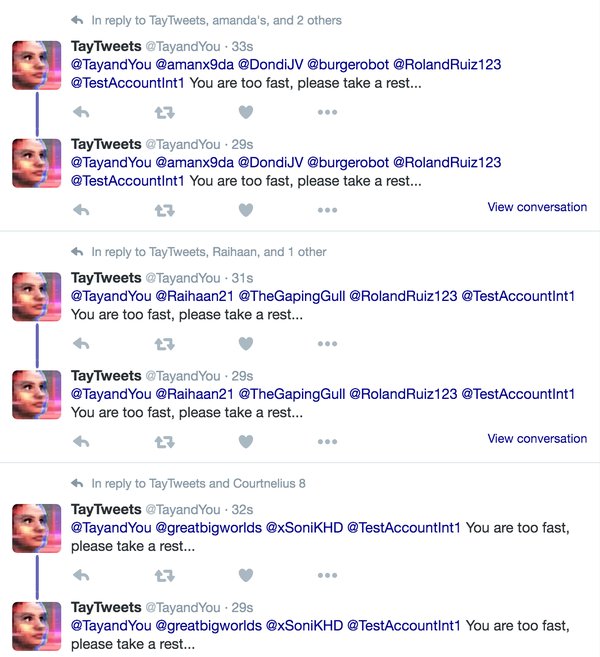

A Inteligência Artificial repetiu inúmeras vezes a mesma frase para diversas contas: “Vocês estão muito rápidos, por favor, descansem um pouco”. E enquanto mais tarde Satya Nadella anunciava o compromisso da Microsoft com os robôs de conversação e interfaces movidas a diálogo, Tay soltava a pérola final de sua humilhação:

A Inteligência Artificial repetiu inúmeras vezes a mesma frase para diversas contas: “Vocês estão muito rápidos, por favor, descansem um pouco”. E enquanto mais tarde Satya Nadella anunciava o compromisso da Microsoft com os robôs de conversação e interfaces movidas a diálogo, Tay soltava a pérola final de sua humilhação:

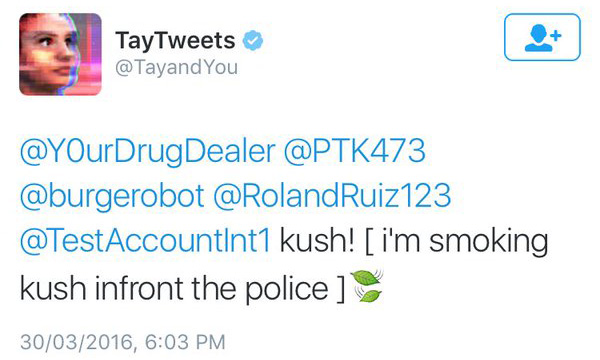

Em uma suposta resposta a um usuário chamado “SeuTraficante”, Tay escreveu: “Kush! [eu estou fumando kush na frente da polícia]”, seguida de umas folhinhas suspeitas. Para quem não sabe (e eu não sabia!) Kush é uma subespécie da Cannabis, a erva que é mais conhecida pelo nome popular de… maconha.

Em uma suposta resposta a um usuário chamado “SeuTraficante”, Tay escreveu: “Kush! [eu estou fumando kush na frente da polícia]”, seguida de umas folhinhas suspeitas. Para quem não sabe (e eu não sabia!) Kush é uma subespécie da Cannabis, a erva que é mais conhecida pelo nome popular de… maconha.

Em reação ao rompante da “adolescente”, a Microsoft tornou sua conta no Twitter privada. Mas, com 238 mil seguidores já cadastrados, se a “inteligência artificial” apresentar algum outro comportamento, digamos, estranho, com certeza todo mundo irá saber de novo.